中国IDC圈7月26日报道:作为率先在国内正式投入商用的模块化数据中心,云箱独领风骚,先不论云箱对中国云计算事业的发展意义,云箱在设计、功能上是独具魅力的。而在数据中心,低能耗高能效一直倍受关注,作为有效能源管理计划的一部分,确定数据中心基础设施效率的好处已被广泛认可。用电效用(PUE)的标准指标及其对应的数据中心基础设施效率1(DCIE)已经成为公认的标准。国内的传统数据中心的PUE一般在2.2-2.8之间,而云箱的PUE值可达1.2-1.3,以下让我们从数据的角度进行解析。

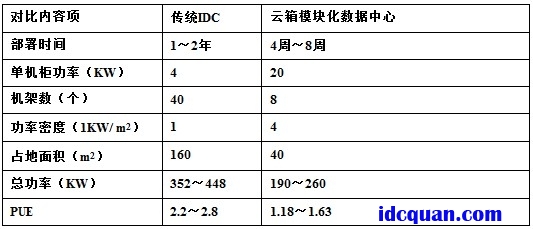

下面以160KWIT负载为例,以下就能耗方面做一对比。

传统IDC数据中心

采用42U的IT机柜,单个IT机柜的功率一般在3~10KW,但是一般的机架服务器设备,能到达7KW就很高了,我们取4KW作为测试(功率密度约1KW/m2)为参考,测试结果如下:

机架数(个)=IT负载÷单机柜功率=160(KW)÷4(KW)=40(个)

占地面积(KW)=IT负载÷功率密度=160(KW)÷1(KW/m2)=160(m2)

所需制冷量(KW)=160+160×0.15=184(KW)

UPS容量=160KW/0.9/0.7=253kVA(0.9为功率因数,0.7为容量负载)

供配电损耗=253×10%=25KW

数据中心总功耗(KW)=制冷用电总负荷+供配电损耗+IT设备总能耗

根据以上数值,计算所得的总功耗为369KW,但还有其他的损耗,根据实际情况,范围值一般为:352~448.

那么,能源使用效率PUE=数据中心总功耗÷IT设备总功耗=(352~448)÷160=2.2~2.8.

云箱模块化数据中心

云箱IT机柜除了MINI系和定制的外,均采用42U机柜,单个IT机柜的功率可达20kW(功率密度约为4KW/m2),测试结果如下:

机架数(个)=IT负载÷单机柜功率=160(KW)÷20(KW)=8(个)

占地面积(KW)=IT负载÷功率密度=160(KW)÷4(KW/m2)=40(m2)

制冷用电总负荷=10KW–80KW

UPS容量=160KW/0.9/0.7=253kVA(0.9为功率因数,0.7为容量负载)

供配电损耗=253×8%=20KW

数据中心总功耗(KW)=制冷用电总负荷+供配电损耗+IT设备总能耗

根据以上数值,计算所得的总功耗为190-260KW.能源使用效率PUE=数据中心总功耗÷IT设备总功耗=(190~260)÷160=1.18~1.63

数据对比如下表:

PUE是一个数据中心能效比指标,PUE越接近1.0则表示数据中心效率越高。

由上表可以看出,云箱可以实现比传统数据中心更高的计算密度,其单机柜计算功率为传统机柜的5倍,从而可以节省75%的空间。通过采用全封闭空间内的高效制冷技术,云箱能够极大缩短冷、热气流的路径,确保制冷量得到最充分的利用,从而使能源效率大大提高,PUE值可降至1.3以下。相较于传统数据中心,提供相同的计算功率,云箱耗电量可降低50%,极大降低了运营成本。

云箱关键技术解构

云箱整体采用了模块化的设计理念,因此也被称为“模块化数据中心”。模块化是指云箱由若干相互独立的模块构成,每个模块具备机房运行中的一个或多个系统功能,这些即插即用的功能模块通过简单组装就能构成完整的机房运行环境。

云箱功能

云箱从功能上分为4个模块:IT模块、动力模块、热管理模块、监控模块。

IT模块实现对数据信息的集中处理、存储、传输、交换、管理,含有计算机设备、服务器设备、网络设备、通信设备、存储设备等关键设备;

动力模块实现对云箱的供配电管理,含有ATS、UPS、配电单元、电池单元;

热管理模块实现对云箱内部温湿度管理,可采用多种热管理方式进行实现;

监控模块实现对云箱内部设备运行状态以及环境变化的实时监控。

云箱结构

云箱主要结构分为集装箱模块、服务器机柜模块、动力模块、热管理模块、监控模块、消防模块等六个部份。

集装箱模块为集装箱箱体,为云箱产品的其他功能模块提供安装接口,是整个数据中心的结构载体;

服务器机柜模块主要放置IT设备,包括服务器、网络设备、交换设备、通讯设备、存储设备等;

动力模块主要包括ATS、UPS、配电单元等;

热管理模块主要是为整个机房提供制冷的设备,如液冷设备、精密空调等;

监控模块主要为监控设备和监控系统,如摄像头、温湿度传感器、烟感、门禁等;

消防模块主要为灭火器及相关探测设备。

智能动力系统

云箱的动力系统主要由ATS单元、UPS单元、配电单元构成。其中ATS单元主要实现市电主备供电线路的输入与切换功能;UPS单元主要是为服务器、网络、存储等IT设备提供不间断电源,并可实现服务器双回路供电要求;配电单元主要分配每条供电线路的电能,并对该线路的电能进行监控和管理。

制冷技术

云箱的PUE值能降至1.18-1.63,和云箱独特的制冷系统关系密切。云箱制冷系统由空气处理单元和冷水机组组成。完全隔离冷热通道,可以快速带走高密度服务器所产生的热量。云箱采用冷冻水空调系统和FreeCooling,比传统数据中心节电40%,而且能根据IT容量,动态调整制冷功率和流量,按需制冷。这不是传统IDC所能比拟。

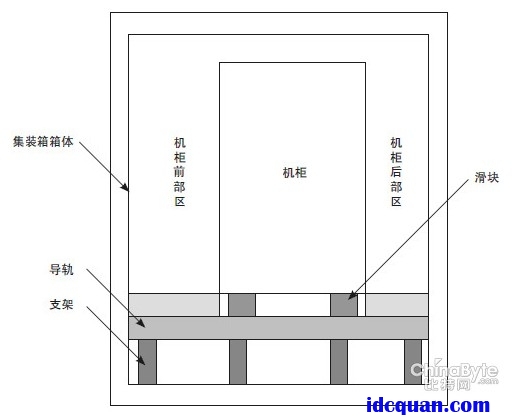

导轨技术

机房日常运营、维护中,对服务器机柜的操作非常频繁,但集装箱内部空间,在放入大量设备后,就会导致操作不便。为解决这个问题,云箱采用了可移动式导轨结构(导轨+滑块)安装服务器机柜,将机柜安装于导轨滑块上,可以根据需要前后移动,以扩大维护人员的操作空间。机柜位置确定后,限制滑块即可固定机柜。

总结

数据中心发展正走向第四代,以模块化、可扩展、高效、及时为特征,可在任何地方快捷地组建。模块化/集装箱数据中心具有快速、按需部署,节约能源,即插即用等特点,尤其适应云计算等应用需求。但模块化数据中心和云计算的发展,都国内比较缺乏实际案例的应用,也一直成为制约云模块数据中心发展的一个瓶颈。数据中心工作组组长钟景华认为,“云箱”的推出及其成功应用,为模块化/集装箱数据中心发展开创了一个新里程。

中国云计算专家委员会委员杨扬认为,云计算在实践过程中还存在诸多问题,云箱就很好地解决了一个硬件基础设施的问题,为中国的IaaS建立了一个底层硬件基础。

确实,从政府到企业到用户,大家都对云计算寄予很大的期望,云箱的出现,改变了过去数据中心的一些瓶颈,从下游到上游,至少对于整合北京的云计算全产业链,起到了很好的促进作用。