现如今的数据中心行业正面临着必须成倍增长的数据处理及网络容量的需求,这无疑会使得数据中心的电力能源分配及合作伙伴所提供的对于电力基础设施解决方案的拓扑结构的保护遭遇前所未有的巨大挑战,而这其中就包括不间断电源(UPS)模块,其必须具备更广泛的电力可靠性,以防止工具或系统电源发生异常或故障。这一水平的可靠性不仅是按时间长度(几小时或几天)来计量的,而且还会通过一系列的事件(如,“以多年来单一事件”测得)的数目来计量。对于典型的处理关键任务的数据中心而言,防止并处理故障事件的数量与其持续运行时间同样重要。

而关键任务电力行业已经以一系列依赖于设备层和配电冗余的UPS保护拓扑就上述问题进行了广泛的回应。这种冗余无疑提供了关键水平的可靠性、负载共享和效率,但这一切同时也是以不断飞升的资本支出成本(CAPEX)和运营支出成本(OPEX)为代价的。

这些冗余拓扑(稍后介绍)能够为四级数据中心以较高的水平提供正常运行时间协会(Uptime Institute) [1] 所估计的每年少于一个事件和每年不到0.8小时的停机时间的可靠性。但这不禁使我们要问如下一系列的问题:“其成本如何?”和“这是对怎样的数据中心而言?”或更简单地说“我们如何才能选择恰当的关键供电系统,以匹配我们的数据中心的功能呢?”

合理精简冗余和可靠性

随着数据中心市场日渐变得多样化,某些领域和应用程序将仅仅只需要很少的关键电源保护(例如,正常运行时间协会处理云计算社交媒体或搜索引擎数据的一级数据中心);其他的包括有诸如严格百分百保证正常运行时间,且遵循服务水平协议(SLA),需要处理视频流媒体,电子商务和金融/股票交易的关键任务应用程序评级为III/IV的托管数据中心;还有一些属于中等水平评级的数据中心应用程序,其对于正常运行时间和可靠性会根据需求的不同而有所不同。

上述这些不同的正常运行时间的排名均需要不同级别的冗余,且必须由UPS系统拓扑交付传递。每种拓扑结构均可以采用多种不同的配置来实现。最佳的UPS系统的选择取决于如下重要因素,包括冗余、负载功率(千瓦)、故障隔离、负荷共享、资产利用率、容量扩展和总拥有成本(TCO)的CAPEX和OPEX测量。

N系统拓扑

N系统是最基本的关键配电拓扑结构,其中“N”是以千瓦为单位进行的负载能力测量。这些系统不在并联位置安置UPS模块(或冗余),从而降低了系统的可靠性。

图1:N系统的拓扑结构。

该系统的拓扑结构也有多个“单一”的故障点,每一到两年的故障事件[2],这使得其成为最不可靠的。一个单一的故障点被定义为一个系统的一部分,如果其发生故障失败,将停止整个系统的工作。例如,可以以典型的美国公用事业电网以每年平均24次故障事件[3]在ITIC/CBEMA[4]曲线之外作为参考。再次强调,对于某些低风险的应用程序,如内部信息技术(internal information technology,IT)的处理流程失败,对一家大型企业或集团的用户并没有影响,这种N系统拓扑结构可以是非常有效的。

N系统拓扑结构的主要优点是低初始部署和运营成本(不包括计划外停机相关成本费用)。另一大优点是系统资产的高利用率。一个N系统拓扑结构的UPS模块,具有满额定负荷80%到90%的设计负荷。

N+1系统拓扑

一个N+1系统拓扑开始添加冗余组件,以提高可靠性。同样“N”是载荷能力,而“1”则是指在系统中的一个额外的UPS冗余电源保护。这些系统以并联结构运行的UPS模块,但他们仍然有多个单点故障,包括UPS模块的输出并联总线。一个N+1系统也缺乏冗余的分配路径,因此,估计每年单点故障的一个事件会有一定的故障风险失败率。

图2:并联冗余N+1系统。

这种拓扑结构被广泛应用于呼叫中心和并非100%遵循SLA的托管数据中心。其也适用于任何一家不太依赖于互联网提供服务的企业。

一款N+1系统的拓扑结构,具有较少的冗余元素和更高的利用率,具有较低的初始成本和低运营成本。其更高的利用率取决于所需的N负载的UPS模块或发电机的数量。N负载的UPS模块具有满额定负荷80%到90%的设计负荷,并具有一个额外附加的UPS模块和发电机添加到系统中。例如,一个由两个UPS模块组成的N+1系统,将具备正常模块40至45%的加载,而一个由五个模块组成的N+1系统将仍然被限制到65%到70%的模块加载。

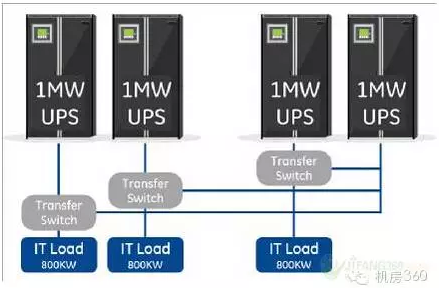

块冗余(catcher)系统拓扑

这种并联的电源架构的另一个变化是块冗余系统拓扑结构,通常被称为一个catcher系统。这种方法是一种经济的方式用来提高系统的可靠性,而无需一个完整的2N系统。它依赖于静态转换开关(STS)和catcher UPS模块的即时处理突然转向,或阶跃载荷,通过从受影响的UPS到后备式UPS转移负荷的能力。然而,在大多数块冗余的部署实现方式中,在STS也是一个单点故障,虽然该UPS模块的利用率得到提高,但其仍限于70-75%的负载以确保冗余。

图3:块冗余(catcher)系统。

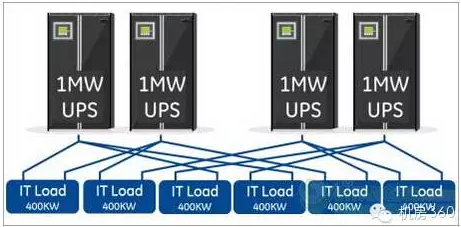

共享冗余(4N/3)系统拓扑结构

一个共享冗余4N/3系统拓扑与块冗余拓扑非常相似,除了负载分散在多个路径和所有的UPS负载,以防止“catcher”系统的块加载。4N/3和3N/2变化是共享冗余拓扑最常见的形式,而这些拓扑结构的利用率水平是在60-70%的范围。共享冗余系统的设计,如3N/2,是UPS大容量(兆瓦/MW)与大临界负荷(MW)的比率计算得出,所以UPS的大负荷利用率将是2兆瓦(负荷)/ 3兆瓦(UPS),这相当于67%的效率。

图4:共享冗余4N/3系统。

如图4所示,这种拓扑结构还需要一个明显的电缆和配电基础设施,这增加了初始投资资本和安装成本,并使系统规模化更加困难。此外,该系统在UPS的输出的功率分布方面具有单点故障。

无论是块冗余和共享冗余系统,二者均能够比N+1系统提供更高的可靠性,据故障率估计其每年不到一个事件。这种性能非常适合于大多数实时交付数据和应用程序对于服务、收入甚至是企业声誉并没有直接或明显影响的企业。但这些系统的挑战在于,其大利用率是限制为小于70-75%,而由于限制了跨电力基础设施共享负载的能力,在实际使用时,利用率通常要低得多。UPS和关键电力资产的块冗余或共享冗余系统会变得滞留和未充分利用,由于数据中心在其运行过程中,IT负载/服务器的添加删除,升级或转移,系统实际部署的关键负载会经常发生变化。

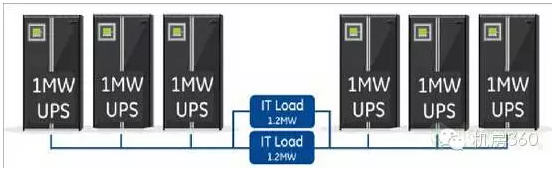

系统加系统(N+N)拓扑

系统加系统(或N+N)拓扑结构,采用了独立的和冗余的配电系统。此拓扑结构可以设计与任一系统中的N组件或每个系统中的N+1组件运行。两个独立的系统提供并发维护,而在某些设计中可以容错。

图5:系统加系统(S+S)。

系统加系统的拓扑结构提供了非常高的可靠性,但其也有高的初始成本和TCO,同时结合了低资产利用率(大设计负荷40%到45%)。估计拓扑结构在一个五年的时间段内只有一个到二个计划外中断(负载下降)。这些设计通常用于企业或设置高可用性的金融服务,每五年测量单一事件是保证服务的核心(如一个SLA托管中心),对收入或企业运营风险和责任会产生显著的影响。

总结

数据中心行业是动态的、变化的。系统可靠性的变化需要匹配数据中心的“使命”和“关键任务”的交付。而现有UPS系统拓扑结构的演变表明,数据中心市场有一系列的系统可以提供最佳水平的高可靠性(N+N),但其成本也非常高。其他选择包括可以降低成本但具有低得多的可靠性的系统(N或N+1系统);或能够提供一个较为折中的可靠性水平的(块或共享冗余)系统,这需要在成本,可靠性和利用率等方面进行复杂的权衡。该行业的下一个挑战将是推动这些界限的模糊,以寻找新的、能够提供冗余和适当水平的可靠性,同时降低资本支出和运营成本,并产生更低的总体拥有成本的系统解决方案。

关于作者

本文作者Brad Thrash是GE的关键电源业务部门的产品经理,其所在的部门是一支专业的团队,正在与GE公司的数据中心、通信、计算和客户团队共同努力,绞尽脑汁地满足公司不断增加的能力和永不满足的业务需求。这些来自客户的挑战帮助他们得以进一步的提高数据容量,建立更好,更智能化的数据基础设施,提高运营收益。Brad拥有机械工程学士学位,是有执照的专业工程师。他同时也是美国电气和电子工程师协会(IEEE)和美国机械工程师协会(ASME)的成员。Brad也是绿色网格组织旗下电力工作团队的成员。

脚注

[1] Uptime Institute正常运行时间协会,http://journal.uptimeinstitute.com/explaining-uptime-institutes-tier-classification-system/

[2] Uptime Institute正常运行时间协会《分级站点定义基础设施的性能调查》,W. Pitt Turner,2008,9页

[3] 美国电力研究所(EPRI),《配电系统电能质量评估:第二阶段:电压暂降和中断分析》2003年3月,表5-12,5-25页http://www.epri.com/abstracts/Pages/ProductAbstract.aspx?ProductId=000000000001001678

[4]信息技术工业委员会/计算机商业设备制造商协会的曲线是电压抗扰度要求,即协助关键电源理解UPS有望解决什么技术问题。