据国家数据局,我国生成式人工智能的快速发展,10亿参数规模以上的大模型数量已经超过100个;据银河证券,AIGC不断向终端侧及行业应用渗透,国内未来5年智能算力规模年复合增长率预计将达到52.3%。

大模型的快速发展,智算需求与规模的高速增长,为数据中心带来了巨大的产业机遇,但传统数据中心想要承接智算需求力有不逮,需要进行一系列优化,其中尤以液冷改造受关注。

面向未来,液冷是大趋势,改造势在必行,是数据中心开展智算业务、降低PUE的必要条件。

GPU芯片功率能耗居高不下及高密度发展趋势下,数据中心散热需求快速提升,应用液冷是必然选择。以GPU代表性企业英伟达为例,其3月份最新推出的Blackwell GPU的训练性能是上一代Hopper GPU的4倍,推理性能是30倍,能源效率约25倍。不过,这样的优化下,B200的能耗依旧达到了1KW。服务器可装载约4到8颗芯片,以此来看,每台服务器能耗可达8KW,风冷已经难以满足需求。

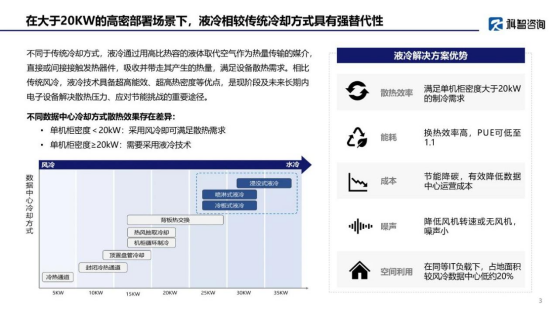

据科智咨询联合中国信息通信研究院产业与规划研究所发布的《中国液冷数据中心市场深度研究报告》(以下简称液冷研究报告),单机柜密度<20KW,采用风冷可满足散热需求;单机柜密度≥20KW便需要采用液冷技术。

截图自《中国液冷数据中心市场深度研究报告》

如果数据中心搭载了B200或类似功率的GPU芯片,以传统风冷的散热效率,每个机柜只能搭载两台服务器,这既会造成资源的浪费,也不符合数据中心业务发展需要。想要承接智算需求,实现高算力,减少成本,获得更多利润,数据中心必须向高密度发展,而风冷难以满足制冷需要,液冷的改造与应用也就成为必须。

同时,低PUE发展要求与节能减碳发展趋势也让数据中心越发需要液冷。

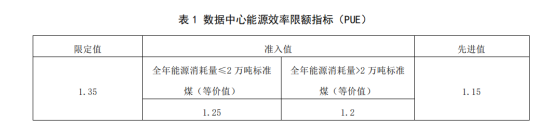

目前,已有多项政策在推进数据中心降低PUE,部分还明确了明确液冷占比。如北京市2023年12月发布的地方标准《数据中心能源效率限额》,相较于2019年第一次修订后的标准,限定值从1.4降为1.35,先进值从1.2降为1.15。准入值不仅从原来的1.3有所降低,还更为细化,年能耗≤2万吨标煤的PUE准入值为1.25,年能耗>2万吨标煤的PUE准入值为1.2。

截图自《数据中心能源效率限额》

近期发布的《上海市智能算力基础设施高质量发展“算力浦江”智算行动实施方案(2024-2025年)》指出,到2025年,上海市新建智算中心PUE值达到1.25以下,存量改造智算中心PUE值达到1.4以下。智算中心内绿色能源使用占比超过20%,液冷机柜数量占比超过50%。

数据中心里,散热是仅次于IT设备的用电源,想要实现低PUE必须优化散热,而液冷的高效率制冷可大幅度减少散热的电能消耗,能够让数据中心能够实现低PUE,有效降低碳排放,符合政策引导要求与绿色化发展趋势。

由此可见,智算需求下,面对高密度发展与低PUE要求、节能减碳需要,数据中心进行液冷改造毋庸置疑。

回归现实,液冷的改造已经在进行,部分数据中心在应用液冷后已经明确利好,但到了具体的数据中心,是否要将散热改为液冷可能依旧需要综合考量。

数据中心应用液冷的前后对比目前已有案例,如中国移动首例液冷机房试点项目。据介绍,其基于冷板式液冷技术,结合中国移动长三角(苏州)云计算中心的建设和现有资源池业务部署的架构,实现单机柜功率从传统的7KW提升到15-20KW,机房散热能耗降低50%-60%,数据中心PUE值降低至1.25以下。经测算,每年每模块机房可节省电费约60万元,节约空调电费50%以上。

液冷的优势显而易见,不过,数据中心应用的目的是为了承接更多业务、提升上架率,液冷是满足智算建设的手段,但并一定能够带来市场。并且液冷改造的难度、成本投入等不尽相同,要结合实际来考虑。

首先要评估数据中心当前运营情况,包括智算需求、数据中心自身竞争力等。

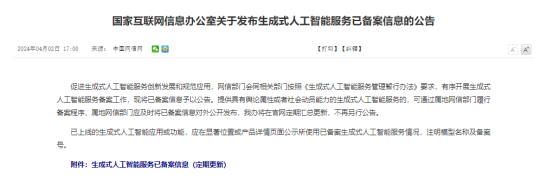

从市场来看,北上广深是智算的主要需求地。根据中国国家网信办发布的关于发布生成式人工智能服务已备案信息的公告,截至2024年3月,共有117个大模型履行了备案程序。从属地来看,117个大模型中,51个来自北京,24个来自上海,19个来自广东。来自广东的大模型备案单位主要位于广州、深圳。

截图自国家网信办官网

由于网络传输效率与成本因素,临近市场的数据中心更具优势,承接智算业务的可能性也更大。不过,这些地区往往也是智算中心聚集区,竞争较为激烈。

以大模型备案数量最多的北京为例,根据IDC圈不完全统计,截至目前,带有“智算中心"的项目,北京有13个,临近的河北13个、内蒙古13个、天津5个,北京及临近地区的“智算中心”合计44个。大量智算中心的出现,意味着即便数据中心进行液冷改造后,能够满足智算要求,但机柜的上架率却可能需要打一个问号。

其次,便是液冷改造选择何种模式,并对液冷化的程度、改造中的一系列问题进行评估。

当前液冷主要分为浸没式、冷板式、喷淋式。浸没式液冷为整机柜形式,喷淋式改造机柜需要增加必须装置,这两类模式对于楼层承重等均有特殊要求,改造过程复杂且成本高昂,且喷淋式应用较少;相较于前两者,冷板式兼容性高,成熟度高,改造建设难度小,成本较少,拥有商用基础,是目前改造应用的主流。

当然,这并非绝对,主要因素还是依据机柜密度与功率来决定,据测算,冷板式在100KW以内的机柜上散热效率较好;相变浸没式液冷则可支持150KW以上机柜,不过目前此类液冷一般是应用在超算上。

同时,考虑到成本问题,传统数据中心在进行液冷改造时或许还是要首选部分改造,并与原有风冷系统进行融合,以避免盲目跟进,减少投入。

此外,液冷的改造不只是“散热改造”,数据中心是一个整体性的工程与系统,散热系统的改造会引发包括软硬件兼容、硬件升级等在内一系列优化与升级。

如改造后,整体功率能耗提升,需要更强大的电力支撑,要进行电力扩容,这涉及多方面的因素,包括市电供电、UPS不间断供电、柴发应急电源等,要进行综合性的升级改造。同时,数据中心对此均有着规范性的要求,以应急电源来看,据《GB 50174-2017数据中心设计规范》,A级数据中心应是(N+X)冗余(X=1~N),柴发燃料存储量宜满足12h用油。

智算对于网络配置同样有着极高的要求,需要提升网络带宽,优化布线情况。智算训练与推理会涉及到大量的数据,保证网络畅通是基本要求,400G乃至800G、1.6T被更广泛地提及,综合布线也在根据要求进行优化,以满足网络的互联互通。

最后,则要面对液冷改造完成后的长期运营问题。

液冷与风冷的制冷原理不同,运维方式也存在差异。数据中心运维时间可长达几十年,良好的散热制冷是数据中心正常运转的必要条件,一旦出现故障需要及时处理,而液冷与风冷的差异导致原有经验及处理方式并不适用,这就需要对运维人员进行专业培训。

现实中,由于液冷的应用依旧处于相对早期阶段,相关培训体系并不完善,同时液冷标准的缺失,不同厂商生产的产品可能存在一定差异,此类培训往往由液冷厂商与数据中心共同完成,以实现对液冷散热的良好运维。

值得一提的是,液冷标准的制定正在加快,团体标准、白皮书等日渐增多,如由中国通信工业协会数据中心委员会、中国计量科学研究院主编,液冷产品厂家、集成商、液冷数据中心业主、检测实验室等众多参编单位共同编写的《数据中心冷板式液冷测试验证技术白皮书》,其概述数据中心液冷技术的优势和面临的问题,借助国家质量基础的方法论,通过测试验证技术的应用,从产品、系统、项目三个层级,探讨了测试验证技术对冷板式液冷技术可靠性、能效提升等维度的影响。为推进液冷的应用,相信国家标准制定的步伐也将加快,这对于降低成本、推进国产化进程将起到巨大推动作用。

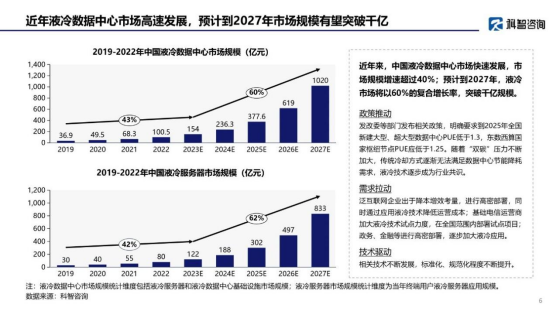

截图自《中国液冷数据中心市场深度研究报告》2

综合来看,当下阶段,具体的数据中心在进行液冷改造时需要谨慎对待,要考虑市场需求与成本等,需要与成熟的厂商谋取合作,如选择拥有全链条研发、生产、服务能力的曙光数创,或有着完善液冷改造计划的宁畅等。同时,也应意识到液冷改造与应用的大势已经不可阻挡。据业内人士,目前液冷在数据中心上制冷散热中占比约为5%—8%,在机柜密度提升、功耗提高,PUE要求越发严格的情况下,数据中心液冷应用会在未来两年实现快速提升,到2026年可实现30%的渗透率。据液冷研究报告,预计到2027年,液冷市场将以60%的复合增长率,突破干亿规模。