中国IDC圈6月19日报道:数据中心模块化最近较为热门,笔者从一个google的集装箱数据中心专利(其实该专利在2009年已经公开,网络上也有不少相关图片),以及网络上相关Google的集装箱数据中心的视频,第一部分介绍了谷歌数据中心原理。下面看看制冷。

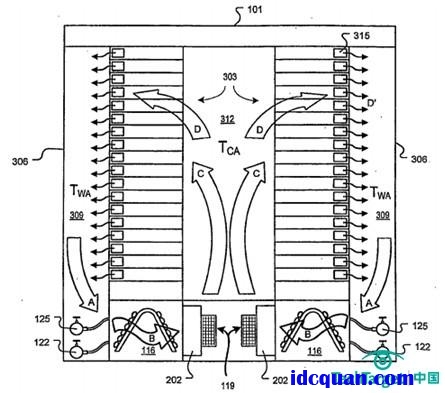

下图是整个集装箱的截面图,这个图更有助于大家看到其气流组织,由机柜底部送出的冷量在中间的312冷池内被两侧的服务器吸入,经由服务器的风扇315吹到服务器尾侧的309热通道内,再经地板下的空调盘管116制冷后由离心风机119吹回冷通道内,形成如下A?B?C?D的整个气流循环,气流组织非常短,风机能耗及冷量传递损失都很少,效率很高。

标准集装箱的宽度只有2.35米,考虑两排机柜并列,还需要冷通道维护空间及两侧热通道回风需要,这里可以推断出google的服务器深度实际是很短的,初步估计含机柜不超过700mm.这种短宽深度的设计也非常适合于服务器散热,较为容易实现高温服务器的目标,据google的介绍,其冷通道送风温度高达27度甚至更高,因此提升冷通道送风温度的节能效果非常明显。

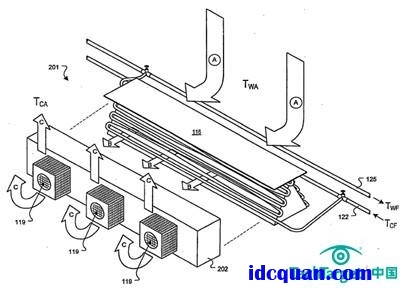

下图的空调特写部分更为清晰展示了其原理,其中116为A字型空调盘管,122供水管和125回水管通过快接软管连到该空调盘管上,降温后的冷空气由导风槽202及离心风机119甩到架空地板上的冷通道内,集装箱内的热量由空调冷冻水带到集装箱外。每个空调盘管对应三个风扇,冷却风扇速度可变,并可以精确管理,保证风扇在能够冷却机架的前提下运行在最低速度。

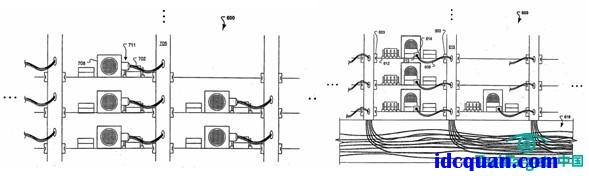

Google集装箱数据中心的设计着重于“电源在上,水在下”,机架从集装箱的天花板悬挂下来,冷却设备在机架下面,让冷空气通过机架。上图是服务器尾部的电源线连接,下图是服务器前部的网络连接,但实际根据google公布的集装箱数据中心视频,服务器的供电和网络接口都建设在冷通道一侧,实现完全的前维护或者冷通道维护,因为服务器后面热通道的宽度实在有限,难以进人维护,以及热通道的温度高达40多度,也不适合运维人员高温操作。

据google自己公布,其IDC的PUE值从2008年第三季度的1.21下降到2008年第四季度的1.16.PUE 为 1 表示数据中心没有能源损耗,而根据2006年的统计,一般公司数据中心的能效比为 2.0 或更高。Google 的 1.16 已经低于美国能源部2011年的1.2 的目标。Google集装箱数据中心实现低PUE的几个最佳实践方法大家可以从参考资料的视频地址中找到。