本文将回顾热量对计算机设备的影响以及改善冷却的部分好处,然后再根据传导和强制对流换热的一些简单原理,以及对高架地板下和设备外壳内的流体动力学的理解,就如何实现冷却效果的改善提供一些见解。

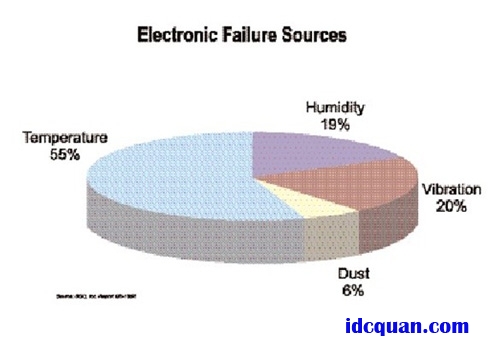

热量是电子设备的敌人。根据BCC,Inc.的“ReportGB-185R”,超过半数的电子故障由温度造成,并且由于这些热量源于不断升高的晶体管密度和运行速度,我们可以得出一个合乎逻辑的结论:在其他条件均相同的情况下,电子故障率也将不断攀升。事实上,根据由IBM、HP、Dell、Nortel、Cisco等组成的“行业冷却协会”发布的信息,我们目前正处于大多数计算与通信电子设备热密度(瓦特/平方英尺)增长的高峰(据UptimeInstitute(运行时间协会)的白皮书报告)。

对于2005-2007年前后曲线的平滑部分,我们不能据此认为只需要冷却在可预见的未来将不大会翻倍的热负荷。这一预测基于协会起初对于摩尔定律的假设,即每个芯片的晶体管数量在十八到二十四个月内会翻一倍,而含有这些芯片的主热驱动器最终将会达到物理边界。发表这个报告之后,戈登摩尔预计这一密度增长趋势至少还会再持续十年,因此我们现在可以预计处理通信设备的热负荷截至2005年将会翻倍,达到极热的6000+瓦/平方英尺,而服务器和存储设备的热负荷再过三年将会增加到2000瓦/平方英尺,六年后将会再增加1000瓦(保守假设晶体管数量增长与温度升高之间持续呈线性关系)。

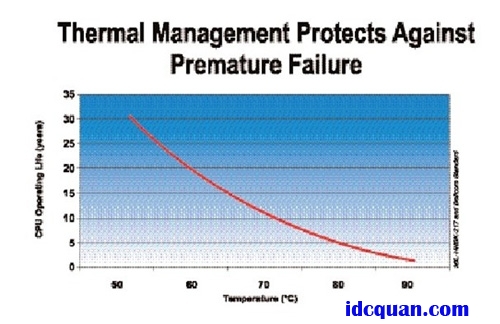

有些不知名的声音声称一些芯片制造商已经能够制造明显更快且更强大的微处理器,但是由于缺乏应对多余热量的解决方案而无法将其投入实际应用。因此,无论是在芯片级、电路板级、壳体级或机架/机柜级,每一个为这些微处理器的冷却做出贡献的人员都会成为新一代计算能力的推动者。温度会以许多不同的方式影响IT硬件,并且看似无关紧要的变化经常会对性能和经济性产生重大影响。Arrhenius反应导致电容器使用寿命和半导体性能在高温作用下下降。有一个很灵验的经济法则,即环境温度每升高10°C,IT硬件的长期可靠性便会降低50%.事实上,美国军方标准和Telcordia标准均将CPU使用寿命与温度相关联。有趣的是,我们注意到大多数CPU的工作温度范围上限均在95°C上下,但是MIL-HNBK-217和Bellcore数据却表明,在此温度水平下持续运行将会使CPU寿命限制为一年或更短时间,而降低5°C竟然可以使设备的预期寿命延长三倍。

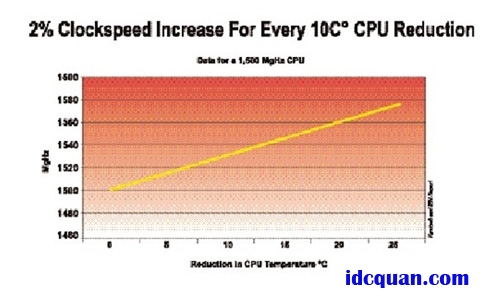

温度还会影响时钟速度。对于1500MHz的CPU,温度每降低10°C,时钟速度便会升高2%.2%可能看似不是特别明显,但是对于使用2RMU服务器专门处理大量事务的较大数据中心而言,丧失这一2%的额外事务处理能力,便意味着每二个半机架便需要另外购买并安装一台本不必要的服务器。

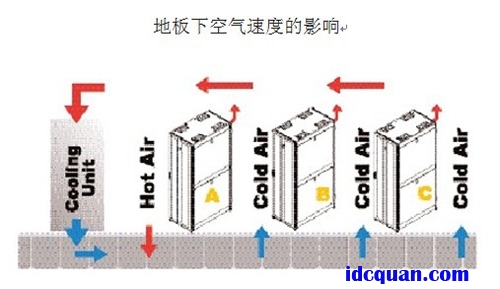

了解高温对于CPU的影响以及对IT硬件进行更大程度冷却可以获得更高性能和经济利益的前景,我们见多识广的机房经理需要经受住投入更多机房空调机组(CRAC)或仅仅调低恒温器的诱惑。在有些情况下,这些举措仅仅是浪费;而在另外一些情况下,较冷的空气实际上可能会导致产生更严重的散热问题。第一个推荐的措施是管理地板砖下的空气移动,然后再管理冷空气实际输送到设备的方式。在这些措施执行妥当后,我们看到CRAC退出服务,并且恒温器的温度升高,而冷却效果却得以改善。

正确的空气管理取决于强制空气对流热传导率冷却设备的原理至少有着基本的理解。大多数的机架安装设备采用风扇冷却。尽管有一些将空气由一侧移至另一侧的独立产品平台,但是通常情况下,还另设有10-30台CFM轴流式风扇以将空气由前端抽出,然后排到后端。在设备内部,热传导在微处理器(或其插座)或其他热源与散热器之间直接接触的分子相互作用时发生。当小型轴流式风扇从设备前端抽出的空气流过散热器时,便发生强制通风对流热传导。此函数可以用以下方程表示:

Q=hA(Tw-Tf)

其中q=热传导率

h=对流热传导系数

A=表面积

Tw=表面温度

Tf=流体温度

历史实践和传统观念通常会关注将热量由机柜中排出,并且纠结于热点问题(通常是机柜的后端上方),而强制通风对流热传导原理却清晰地表明:对于CPU性能和寿命的真正益处源于将最冷的空气直接输送到与微处理器相连的传导表面。事实上,对于传热的动态过程,输送的空气的温度(Tf)是设备安装人员与用户唯一可以控制的变量,也是空气流动管理的目标。

管理空气流动非常简单,就是使空气流动到需要的位置,而此过程的第一步是减少浪费的冷送风–从地下逃逸到没有起到冷却作用之处的空气。TritonTechnologies曾针对一百多个机房和数据中心中的地板冷却空气绘图,并且发现在绝大多数的场所中,输送到室内的空气有50-80%为浪费的冷送风。减少浪费的冷送风好处多多。首先,密封住所有浪费的冷送风的逃逸点将会升高高架地板下的静态压力,从而提升需求点的气流(CFM)。下图说明静态压力与输送的冷却空气CFM之间的关系。

对于浪费的冷送风为50-80%的机房,高架地板下的压力大约为0.01英寸水柱,其通过25%开放的网孔装每分钟输送大约200立方英尺的空气。根据前文讨论的“行业冷却协会”绘制的热负荷曲线,对于一个满负荷机柜所需的冷却要求而言,大约相当于700瓦冷却量的空气输送远远不够。此外,由于一些典型机房的布局方式是让两到四台机柜共用一个网孔砖输送的空气,因此200CFM气流输送的冷却量少得可怜。充分密封住浪费的冷送风以将地板下的静态压力提升至0.025英寸水柱,流过高架地板的气流因此可以由200CFM升高到350CFM,而不必对CRAC或空气处理配置做任何改变,冷却量几乎翻倍,达到1.3kW左右。对于至少一个配备全部设备的机柜,此冷却量现在也充足。但是,充分密封住浪费的冷送风以将地下的静态压力提升至0.1英寸水柱,流过高架地板的气流将增大至700CFM且因此而产生的输送冷却量升高至2.8kW.

需要应对的浪费的冷送风源主要有三个,以实现最佳化静态压力的冷却效果。冷却空气实际上可以从打开的门逸出,然后通过出入点(电缆、电源和管道装置)进入高架地板下的空间内。保持门关闭是简单的常识。但是,在地板下方,大多数的FM200消防系统将需要入口点已密封。否则,这些入口点应以标准的全泡沫、织物或其他柔韧材料密封。另一个浪费的冷送风源是拆除的高架地板。同样地,只要经过一些信息化训练,在不必立即立即进入地下时,通常便会保持高架地板处于原位。大的浪费冷送风源于无意、故意错误布置高架地板开孔的位置。

高架地板开孔可以是开设在高架地板上的任意孔(主要是电缆接入孔)或各种不同的标准格栅和穿孔,这些开孔通常以对角布局部署在机房周围。正如静态压力讨论中所述,唯一的冷空气逃逸应位于需要冷空气进行强制对流以使热源表面传热率更高的位置。因此,针对人体舒适度而布设在露天作业区域周围的网孔砖会有力地降低地下静态压力,降低需求点处的冷空气CFM,降低传热率,并因此降低CPU性能。但是,更糟的是高架地板位于热源附近。我曾见过一个正确布置在热通道和冷通道中的数据中心,然后经理抱怨走在机柜后面时感觉太热,并且在这里通道中安装网孔地板砖以帮助热空气流出。这个措施不仅可以降低输送给安装在机柜中的服务器和其他设备的有效冷却量,还可以在受热空气返回待冷却和重新流通的CRAC之前先对其进行冷却。CRAC效率受源空气温度和回流空气温度之间巨大差异的影响,并且常规的经验法则表明:温差每降低两度,便会导致CRAC效率减少10%,这主要由于保持稳定相对湿度所需要的能源所致。例如,温差降低2°F将会导致20吨的CRAC在一年内产生2000加仑的水,以重新为除湿后的冷却返程源空气增湿。如果位于机柜后端的高架地板中的电缆接入端口处的电缆未密封,则是最严重的浪费的冷送风源。由于一个机柜一个开孔,因此逃逸空气的绝对数量将会比其他来源多出很多。此外,将最冷的空气直接输送到最暖的设备排气,源空气与返程空气温差的降低问题整体将会变得更严重。可以采用全隔垫、全泡沫或特殊的面板隔断里衬(配有毛刷)封闭电缆周围。

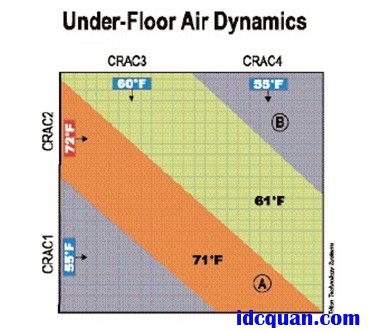

仅仅增大静态压力还不能保证使冷却空气到最关键需求点的流动实现最佳化–在高架地板下方输送的空气必须具有方向性且必须予以正确的管理。高架地板空气管理产品与服务营销商TritonTechnologySystems已积累广泛的实验法研究资料,其中指出不仅CRAC的气流倾向于混合,但如果CRAC的位置彼此成直角,则会导致冷却空气输出模式以地上机房中返程空气模式无法预测的角度偏转。在好的情况下,此模式会导致运转中的冷却设备效率低下,从而导致成本的浪费;在最坏的情况下,会在机房中形成热点,从而危害计算设备的性能和数据的完整性。

“地板下空气动力学”图表说明这些空气流动模式的影响。不同颜色的区域表示地板下空气流动可能的路径,机房地板上方的CRAC返程空气更加可能会与每个CRAC箭头所指示的预期输送路径相反。因此,CRAC-2可能会从B点获得返程空气,其中混合一些起初由CRAC-3输送的返程空气;反之,CRAC-4可能会从A点收到返程空气,中混合一些起初由CRAC-3输送的返程空气,或者CRAC-1也可能会从A点收到返程空气。假设当冷却空气流过机柜中的所有设备时,其温度大约升高15°F,则可以预计会发生混乱,甚至重大事故。CRAC-1收到由A点热点驱动的86°返程空气,并且其温度会继续下降以提供更多冷却量,而未能传输给热点。CRAC-4收到A点的86°返程空气,其中混合一些CRAC-3路径中的75°返程空气,从而持续冷却运行。另一方面,CRAC-2收到来自B点的70°返程空气,其通过来自CRAC-3部分75°的返程空气。如果制冷恒温设置在72°,可以想象,CRAC-2可能会关闭其制冷器,而仅仅将未冷却的空气吹入地上空间中。然而,环境空气将会被输送到房间内最热的位置。同时,机敏的站点管理员会注意到热点并进一步迫使CRAC-1和/或CRAC-4温度降低,从而不幸地导致降低流回到CRAC-2的回流空气温度,从而阻止冷却量输送到房间内的最热点。一旦走上这条路,就很难停下。

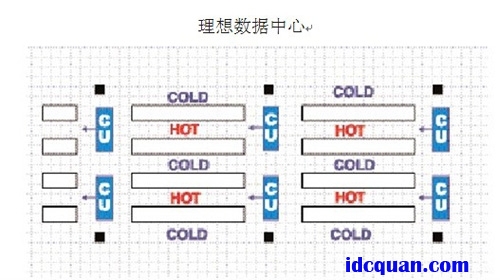

所有空气与所有电缆以相同的并排方向排布的机房统称为“热通道-冷通道”布置,这种方式是使地板下方和上方的空气流向可预测的最佳方式,能够为CRAC故障或服务停机保护提供一定的冗余量,并可以将电缆障碍作为扰动、静态压力降低和CFM遗失的来源加以移除。

最终,当地板下静态压力实现大化从而确保最佳的冷却空气CFM输送,且数据中心中的CRAC和设备机柜的布置最理想时,站点管理员必须避免这一常见的倾向:将最热的设备放置在最靠近CRAC的位置。CRAC直接流出的空气速度经常可能会更高,而无法向上偏转,从而通过太靠近CRAC的网孔地板砖。事实上,根据文丘里效应的物理学原理,流经附近网孔地板砖的冷却空气速度可能很大,足以将室内空气和/或受热的返程气体抽到地板下空间中。因此,不仅靠近放置不能将冷却量传输到最热的设备,而且还可能会导致传输到整个房间内的冷却空气温度上升。本文建议避免将网孔砖布置在太靠近CRAC的位置,并且尽可能将无源的连接设备布置最靠近在CRAC的位置,以使空间利用率大化。

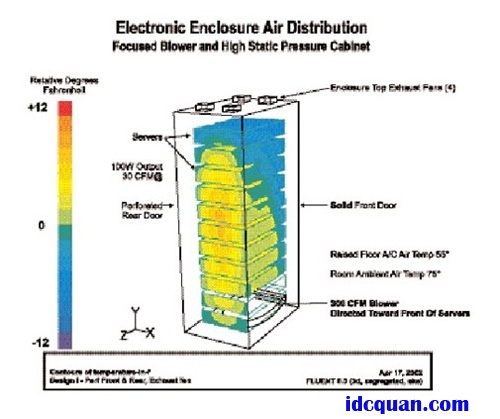

有效布置机房后,机柜/壳体自身也应采用相同的原理。留意机柜内的静态压力和气流管理可以从对于布置机房以实现大化冷却的关注中获得大利益。可以不同的方式应用这些原理,具体取决于总的环境和热负荷。例如,如果浪费的冷送风消除措施已使足够的CFM通过所有网孔地板砖,则机柜不应有门,或者如果出于安全考虑需要配设门,则至少应有60%网孔以保证大的流量且不应配有顶部安装的风扇组件。“足量CFM”将由网孔地板砖所支持的机柜中的热负荷相对所输送的冷却量确定,可以将二者的关系绘制在“地板下静态压力和冷却量之间的关系”线图中。例如,700CFM将提供大概3kW的冷却量,或1.5kW/机柜的冷却量。顶部安装风扇组件可能会不良的后果,甚至会允许返程空气与冷通道中的源空气发生一定程度的混合,因此而造成的温度升高会造成安装设备中的热传导率相对下降。如果机柜后端的布线障碍或其他问题使得小型服务器风扇(10-30CFM)难以将热空气排出机柜,则将空气直接排向热通道并使机柜处于源空气与返程空气之间的后门安装式风扇将会保持系统更高效,更有效力的运行。

另一方面,如果静态压力的改善不足以通过冷通道中心的网孔砖输送CFM,以为机柜中的热负荷提供所需的冷却量,那么可能需要一个更有针对性的方法,将空气直接输送到机柜中,然后再采用一些必要的助推工具配送空气。在此种情况下,对于装有进气的机架安装设备前端的空间,静态压力再次显得很重要。可以通过采用固体面板前门(但可接受周边通风,有时也是最可取的)、在设备间未用的RMU空间中加设盲板以及在设备和机柜侧板间采用一些密封措施,增大静态压力。因此,即使机柜连接在一起(通常没有侧板),两个机柜好至少也要共用一个侧板。除了使机柜前端三立方英尺空间内的空气静态压力大化,此密封措施还可以防止机柜后端的返程废气再次流通或在被抽送到服务器中之前与源冷却空气相混合。顶部安装风扇可以部署在此种配置中,因为其输出不会与设备输入空气相混合。“增压”由旨在将可用的最冷空气直接对准最关键使用点的机构提供。这些产品采用离心式鼓风机将冷却的地板下空气通过喷嘴引导至设备前端,或采用风扇将空气引导至充满填充材料的门,然后再通过通风口或挡板将空气引导至机柜中的需求点,从而实现这一目标。

这些针对性方法的有效性显示在两个电子机柜气流分布计算流体动力学模型的对比图中。“典型的服务器制造商规格”模型显示针对机柜底部的预期冷却量,以及机柜顶部的反直观冷却量。上面的冷却源于顶部安装的风扇通过高气流网格式前门顶部吸入。当顶部安装的风扇未能从设备前端抽取大量空气时,机柜中心仍会有热点,因为网格式柜门具有的阻力比机柜中的设备要少。另一方面,地板下空气温度与设备进气口正对的环境温度之间的差异很大程度上是由于针对性空气输送所造成的。

将空气吹入机柜底部或从机柜顶部抽吸气体的高功率风扇不符合本文所介绍的原理。例如,此类风扇通常会同时从机柜的正面和背面抽吸或吹送冷却空气,因此会冷却废气(返程气体),降低源空气与返程气体之间的温差以及降低CRAC的效率。

数据中心设备的冷却方案不需要是神秘的技法,但是经常需要超乎常识以外的认知,尤其因为高架地板砖的下面发生许多我们看不到的活动。切记以下要点:仅将冷空气用在设备确实需要之处;避免将“用过的”返程空气与源冷却空气相混合;以同一方向,彼此平行的方式布设空气与地板下的电缆,使环境显得简单且可以预测;最本质的东西是输送有效的冷却量,而不仅仅是排掉热空气。