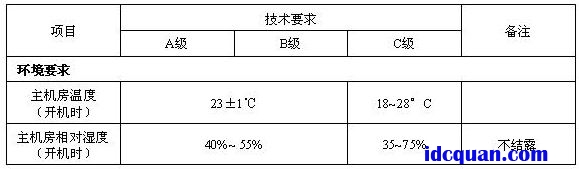

数据中心机房环境对服务器等IT设备正常稳定运行起着决定性作用。数据中心机房建设的国家标准GB50174-2008《电子信息机房设计规范》对机房开机时的环境的要求:

为使数据中心能达到上述要求,应采用机房专用空调(普通民用空调、商用空调与机房专用空调的差异对比不在本文讨论范围)。如果数据中心机房环境不能满足以上要求会对服务器等IT设备造成以下影响:

温度无法保持恒定-造成电子元气件的寿命降低

局部温度过热-设备突然关机

湿度过高-产生冷凝水,短路

湿度过低-产生有破坏性的静电

洁净度不够-机组内部件过热,腐蚀

一)数据中心热负荷及其计算方法

按照数据中心机房主要热量的来源,分为:

设备热负荷(计算机等IT设备热负荷);

机房照明热负荷;

建筑维护结构热负荷;

补充的新风热负荷;

人员的散热负荷等。

1、机房热负荷计算方法一:各系统累加法

(1)设备热负荷:

Q1=P×η1×η2×η3(KW)

Q1:计算机设备热负荷

P:机房内各种设备总功耗(KW)

η1:同时使用系数

η2:利用系数

η3:负荷工作均匀系数

通常,η1、η2、η3取0.6~0.8之间,考虑制冷量的冗余,通常η1×η2×η3取值为0.8.

(2)机房照明热负荷:

Q2=C×S(KW)

C:根据国家标准《计算站场地技术要求》要求,机房照度应大于2001x,其功耗大约为20W/M2.以后的计算中,照明功耗将以20W/M2为依据计算。

S:机房面积

(3)建筑维护结构热负荷

Q3=K×S/1000(KW)

K:建筑维护结构热负荷系数(50W/m2机房面积)

S:机房面积

(4)人员的散热负荷:

Q4=P×N/1000(KW)

N:机房常有人员数量

P:人体发热量,轻体力工作人员热负荷显热与潜热之和,在室温为21℃和24℃时均为130W/人。

(5)新风热负荷计算较为复杂,我们以空调本身的设备余量来平衡,不另外计算。

以上五种热源组成了机房的总热负荷,即机房热负荷Qt=Q1+Q2+Q3+Q4.由于上述(3)(4)(5)计算复杂,通常是采用工程查表予以确定。但是因为数据中心的规划与设计阶段,非常难以确定,所以实际在数据中心中通常采用设计估算与事后调整法。

2、机房热负荷计算方法二:设计估算与事后调整法

数据中心机房主要的热负荷来源于设备的发热量及维护结构的热负荷。

因此,要了解主设备的数量及用电情况以确定机房专用空调的容量及配置。根据以往经验,除主要的设备热负荷之外的其他负荷,如机房照明负荷、建筑维护结构负荷、补充的新风负荷、人员的散热负荷等,如不具备精确计算的条件,也可根据机房设备功耗及机房面积,按经验进行测算。

采用“功率及面积法”计算机房热负荷。

Qt=Q1+Q2

其中,Qt总制冷量(KW)

Q1室内设备负荷(=设备功率×1.0)

Q2环境热负荷(=0.12~0.18KW/m2×机房面积),南方地区可选0.18,而北方地区通常选择0.12

方法二是对复杂科学计算的工程简化计算方法。这种计算方法下,通常容易出现计算热量大于实际热量的情况,因为机房专用空调自动控制温度并决定运行时间,所以多余的配置可以作为冗余配置,对机房专用空调的效率与耗电量不大。本文以方法二推导数据中心机房专用空调配置与能效计算。

二)数据中心机房专用空调配置

设定数据中心的IT类设备为100KW,并且固定不变。根据上述方法二,还需要确定机房的面积。

再假定数据中心的热负荷密度为平均热负荷密度,即4Kw/机柜。也就是说平均每个机柜为4kw的热负荷。

数据中心的机柜数量为:100kw/4kw=25台机柜

按国家标准GB50174-2008《电子信息机房设计规范》有关机柜占地面积计算方法,

取每个机柜的占地面积为中间值4m2/台,那么数据中心的面积为:

25台机柜×4m2/台=100m2

假定环境热负荷系数取0.15KW/m2,则数据中心机房总热负荷为:

Qt=Q1+Q2=100kw+100×0.15=115kw

数据中心送风方式选择:按国家标准要求,采用地板下送风,机柜按冷热通道布置。

机房专用空调选择:机房空调通常分为DX(直接制冷)与非直接制冷(包括各类水制冷系统等),先讨论直接制冷系统的机房空调。不同厂家有不同型号的机房专用空调,以艾默生网络能源有限公司生产的Pex系列机房空调为例,应配置的机房空调为:

两台P2060机房空调,在24℃相对湿度50%工况下,每台制冷量为60.6kw,两台空调的总制冷量为121.2kw,略大于115kw的计算热负荷。

根据国家标准GB50174-2008《电子信息机房设计规范》的数据中心空调配置建议,数据中心通常建议采用N+M(M=1,2,…)配置形式,提供工作可靠性与安全性。

假设本数据中心采用N+1方式配置,即为2+1方式配置3台P2060机房空调,实现两用一备工作。

三)数据中心机房专用空调耗电量与能效计算

机房空调耗电器件有:

压缩机,也是主要的耗电器件

室内风机,

室外风机

室内加湿器

再热器,用于过冷状态下加热

控制与显示部件等,耗电量较少,可忽略不计

a,压缩机、室内风机、室外风机的耗电计算

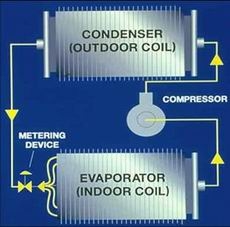

压缩机、蒸发器、膨胀阀、冷凝器组成一个完整的冷热循环系统(空调四部件),其中耗电部分是压缩机、室内风机、室外风机等三个部件。

图:空调四部件循环

详细计算不同工况下的三个部件的耗电量是困难的,但是在大制冷量输出下,空调行业有个标准的参数,即能效比。

能效比即一台空调用一千瓦的电能产生多少千瓦的制冷/热量。分为制冷能效比EER和制热能效比COP.例如,一台空调的制冷量是4800W,制冷功率是1860W,制冷能效比(EER)是:4800/1860≈2.6;制热量5500W,制热功率是1800W,制热能效比COP(辅助加热不开)是:5500/1800≈3.1.

显然,能效比越大,空调效率就越高,空调也就越省电。目前,我国市场上民用空调平均能效比较低,仅为2.6.美国现行的空调能效标准规定输出功率介于2300W到4100W,即小1匹到1.5匹的空调,能效比达2.8即为合格品;能效比达3.2即达到能源之星标准;而能效比低于2.8,不准在美国市场销售。欧洲的能效标准,空调能效水平分为A、B、C、D、E、F、G共7个级别。其中A级高,能效比为3.2以上;D级居中,介于2.8~2.6之间;E级以下属于低能效空调。目前我国绝大多数空调处于欧洲E级水平。而在日本国内的空调器的能效比现在一般都在4.0~5.0左右。

机房专用空调因为采用专用压缩机,所以能效比都在3.3~3.5之间。本例中按大负荷制冷功率115kw,则3台艾默生P2060空调为两用一备,其中备份机在先进的iCom控制模块控制下,只有控制电源工作,能耗很少,忽略不计。

2台P2060空调,总制冷功率为121.2kw,取能效比中间值3.4计算,则四部件电功率为:

P四部件=P制冷/cos=121.2kw/3.4=35.64kw.

b,室内加湿器功率

数据中心机房的环境、建筑条件、密封状态等不同,导致加湿功率不同。

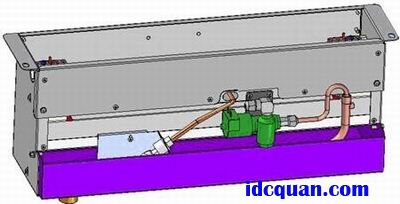

艾默生Pex系列采用远红外加湿器,结构简洁,易于拆卸、清洗和维护。悬挂在不锈钢加湿水盘上的高强度石英灯管发射出红外光和远红外光,在5~6秒内,使水盘中的水分子吸收辐射能以摆脱水的表面张力,在纯净状态下蒸发,不含任何杂质。远红外加湿器的应用减少了系统对水质的依赖性,其自动冲洗功能,使水盘更清洁。

图:远红外加湿器

本例假设一台P2060空调的加湿器即可满足大负荷下的加湿量,查相关产品手册远红外加湿器功率为9.6kw.

P加湿=9.6kw

c,再热器、控制部件耗电量

再热器的作用是当空调过冷情况下为实现数据中心机房温度稳定,进行电功率加热。实际运行中,因为艾默生Pex机房空调采用先进的iCom控制器,彻底解决了空调的竞争运行工况,比如一台空调制冷而另外一台空调加热的竞争运行。

仅仅在控制器故障下,再热器才会工作。因为这是非正常工况,所以再热器的电功率不计入能效模型。

控制部件的耗电量很少,忽略不计。

空调系统总的电功率消耗与能效指标为:

功率:P空调=P四部件+P加湿=35.64+9.6=45.24kw

能效指标:PUE空调因子=45.24/100=0.452

至此,数据中心的PUE为:

PUE=1+PUE供电因子+PUE空调因子=1+0.108~0.114+0.452=1.560~1.566

显然,一个设计与运营良好的数据中心,在空调系统配置正确,不考虑照明、新风机等设备下,能效比应该是小于1.6.

而实际运行的数据中心,能效比动辄大于2.5,非常耗能、非常浪费,究其原因还是用户不太关注数据中心能效指标。

数据中心能效指标PUE的进一步研究工作

上述的模型能够清晰定义数据中心的主要耗电环节,为机房节能设计与运营提供了可行的数学模型。

显然,数据中心节能的重点在于空调部分的能效指标,即PUE空调因子。机房空调的能效指标又与机房的热密度、风道布置、冷热通道、机房建筑热负荷、室外机布置、室内机布置等诸多因素相关,这是本文下一步研究工作需要探讨的。

此外,有关水制冷系统与直接风冷系统DX的争论,也将具体讨论。

空调提供的制冷剂机外循环也是最新的技术,如果能成功产业化,将降低PUE空调因子到0.2左右(一年内平均)。

最后,PUE无论怎样变化,都是大于1的乘数因子。要做到最佳节能,降低服务器等IT设备的功耗,才是最立竿见影。比如之前的总耗电量为1.6,当降低服务器设备功耗为0.8的时候,数据中心总功耗立即降低为0.8×1.6=1.28.IT设备降低了0.2,而耗电量降低了0.32.这就是乘数因子效应。