中国IDC圈7月7日报道:数据中心密度的持续增加给选择合理有效的冷却技术带来了巨大挑战。为此,本文将重点讨论数据中心常用的液体冷却和空气冷却方案,并分析在何种情况下能发挥出大裨益。

众所周知,数据中心的部署是一个牵扯到很多层面的问题,而这些层面又会受各种因素制约,不同的因素需要根据总成本来综合考虑。通常来说,液体冷却方案一般比较昂贵,而且还不一定更有效。而空气冷却则面临机架密度的限制,虽然部分可以通过气流分离策略来克服的。

业务挑战

数据中心计算能力的扩充导致了机架和功率密度的增加,对这些新增加能耗更大的机架如何进行冷却是所有数据中心经理所面临的一个重大挑战。在过去对新增加的服务器添置机房空调就足够满足散热冷却需求。当数据中心在每平方英尺(1平方英尺=0.09290304平方米)范围内的功耗为75-100瓦的时候,采用这种散热冷却方案完全能满足需要,而且能耗成本几乎可以忽略不计。

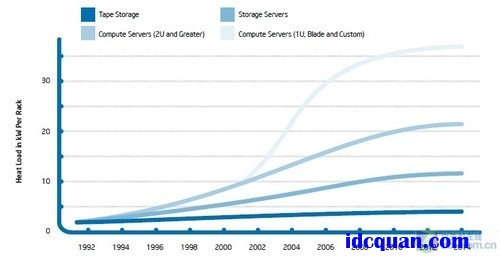

然而,现在的IT设备已经使得数据中心的功耗达到了750瓦每平方英尺,而且冷却带来的挑战和成本已经面临前所未有的境地。功率密度也随着业务增长和设备的扩容而不断增加,从而为冷却技术带来了新一轮挑战。ASHRAE(American Society of Heating, Refrigerating, and Air-Conditioning Engineers 美国热、冷冻和空调工程师协会)公布了一项未来热负荷统计报表。

IT设备中每机架的功率密度(单位为:KW/Rack)

图中表明,从现在至2014年期间,在使用最新产品全部部署的情况下未来的热负荷将达到37KW/Rack.有趣的是,功耗主要不是来自CPU电力的增加,而是来自平台上内存的增加。CPU的功耗控制在技术不断进步的今天已经表现出众,而内存则会因为CPU内核的增加而不断增多。一般来说,高端平台架构需要有足够多的DIMMs或者单核心上有更多的内存容量。而且随着内存核心数量的持续增加,安装的内存也会多了起来。这样一来,内存冷却就成了未来几年散热方案的主要挑战。

技术挑战

数据中心冷却更多的是一个热力学方面的问题。它拥有热源(服务器)和散热通道(通常是室外环境)。当然,数据中心还有其他的热源,限于讨论的篇幅,我们在文中仅讨论服务器这一热源。

根据热源和散热口的温度与距离远近,热源从服务器传递到室外将有一个有效范围,特别是需要多少额外能源来完成这些热源的传递,更需要值得关注。因而,很重要的一点是考虑这些额外能源在整个系统中的使用情况。这其中首先包括支持流体(空气、水或者液体)将热量从热源向散热口移动的能源支撑,这主要会涉及到风扇、泵。

位于Rio Rancho、英特尔的曾经世界第三快的超级计算机中心

另外一个使用能源的地方是冷水机组系统。通常情况下,散热口的温度会很高从而影响到能源输送,冷水机组可以提供一个低温水槽(类似冷水)帮助降低温度。

散热解决方案

现在我们讨论不同类型的散热解决方案。根据前面内容介绍,这里我们将主要讲述液体冷却和空气冷却,然后对它们的优势利弊分别予以讨论。

散热解决方案在数据中心的搭建过程中,扮演着十分重要的作用。在对数据中心进行规划的时候,就需要对散热问题进行前瞻性地谋划,不仅要考虑到当前数据中心散热的情况,更要考虑到如何满足未来几年数据中心不断扩容带来的复杂问题。

液体冷却

液体冷却属于传统的冷却技术。在本文中,我们重点讨论液体冷却机架环境下的表现,而不会讨论液体冷却在服务器上的应用。目前,大部分数据中心都使用液体冷却,它主要应用在机房空调和空气处理方面。液体冷却机架主要是对现有的液体冷却环流应用的延伸。液体冷却也出现了越来越多的热管或蒸气室新应用类型,不过万变不离其宗,我们仍必须考虑空气冷却作为热传递的重要性。

采用液体冷却的数据中心

横跨服务器/机架通道的液体拥有更高的热耗散空间,但同时也会对整个数据中心带来更高的成本,给服务器的使用增添复杂。由于成本和复杂性因素,很多公司(比如英特尔)并不看好这一冷却方案,并期待着在某些专门的高密度应用领域减少这种冷却方案的使用。

应用在机架上的液体冷却可以采用多种形式。其中一种就是对门板进行冷却——也就是机架后方的面板。通过冷却周边空气使得机架的温度能保持在室温的正常状态下。

液体冷却

液体冷却

液体冷却机架的另一种方式就是采用封闭液体冷却机架,也就是在机架的全身都包裹着一层含有气流的绝热层,这种方式通常都是在底部通过热传递来对整个机架进行降温,在一个相互连接的液体冷却系统中热量获得疏散。这种设置的优势是空气流和热量在室内会保持中性,不至于太热,从而不会有噪音。潜在的缺点是,冷却系统一旦出现故障,需要手动开启柜门以避免过热。

液体冷却效率

很多人声称液体冷却效率能解决数据中心带来的电力问题。如果从CPU到冷却塔都采用液体冷却方式,那么冷却子系统效率自然会很高。不幸的是,除了CPU还有很多平台需要进行冷却,因此服务器组件的散热需求注定要有空气冷却进行补充。

另一方面,如果我们需要对平台的其他组件进行冷却,我们可以利用空气来对整个平台进行冷却,从服务器到机架外部,空气冷却都无时不刻不在起作用。一般说来, 它会通过空气将服务器热源传递给机房空调系统或者空气冷却系统。数据中心往往都配有很多机房空调系统或者空气冷却系统,规模或大或小,不过它们往往都是针对整个设施中心而不是某个机架级的冷却系统。数据中心的冷却系统一般都混合采用这两种方案。在某些情况下,空气存在机架的散热液中,但液体会将热量散播到室外。

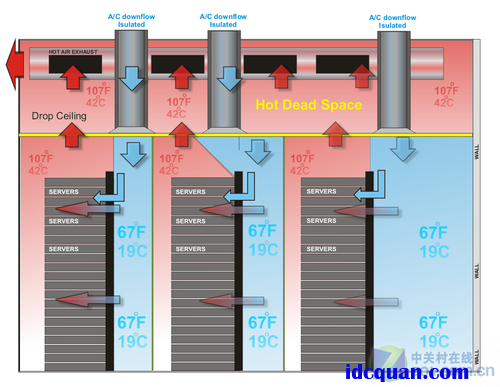

冷热通道隔离散热

空气冷却不足

谈到空气冷却的不足,往往会引起对健康问题的激烈争辩,但我们需要结合理论对实际情况进行分析。实际情况方面的限制因素主要是要考虑到当前的设计规划。如果数据中心的空间有限,地板存有不少障碍物、风机容量也有限,那么需要采用空气冷却能够支持的最优方案。数据中心运营商需要根据自身实际经验来决定如何将空气冷却实现最优。而如何做出决定,关键在于对比机房气流与供应商冷却需要的气流之间的比例。

而对于空气冷却的理论因素方面,更多的是基于服务器而不是机房。服务器供应商提供热量管理系统,通过随机的系统风扇调节气流,帮助冷却CPU和服务器中其他所有组件。因此,如果机房能满足服务器的气流需要而无需在数据中心里面循环反复,那么散热的瓶颈就会是在服务器上而不是机房本身。

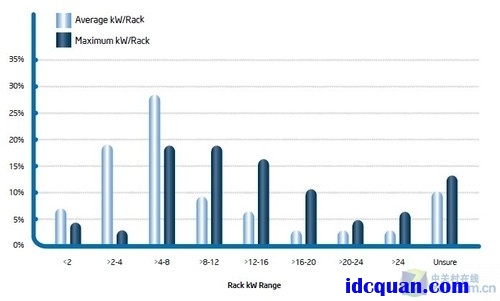

目前,英特尔已经成功推出实现30KW热密度的空气冷却机架系统,在2014年将能实现大规模应用。

气流分离

空气冷却能成功达到30KW热密度,主要依赖于气流分离技术。最先使用同时也是使用最为常见的技术就是,将冷热通道进行隔离。在这种方法的指导下部署机架,机架的入口与连接至冷却系统的冷通道相连,然后将热气流通过热通道回传至冷却系统。根据服务器的不同,整个机架内的气流流速应该为800-1200(每分钟立方英尺CFM)。

高机架密度和平均机架密度条件下的不同热密度

当然,空气冷却也能轻易超越以上所指的范围,但它会增添额外的成本和复杂性。如前所述,关键是实现气流分离。

总结

液体冷却是否是高密度机架的良方呢?并不是。那液体冷却在某些情况下是否是理想之选呢?肯定是。特别是受现有数据中心有限架构制约而未能充分发挥冷却性能的情况下,液体冷却方案可以成为一种不错选择。不过,无论在何种情况下,在评估扩充冷却方案可行性之后需要有一份详细的工程分析。

对于CIO来说,首先要舍得花功夫去分析和思考数据中心的冷却工程。因为每一个数据中心都有各自的特点,只有通过准确评估,充分理解自己所负责的数据中心,了解其散热特点,才能提出一个切实可行而又能保证高效率低TCO的解决方案。