数据中心的发展趋势

最近几年来,互联网的快速发展导致了诸如电子商务、社交媒体和互联网金融服务等新兴业务的出现。而随着智能移动设备的使用的增长,人们的工作学习和个人日常生活都比以前任何时候更紧密地连接到互联网,进而创造了对数据的巨大需求。而鉴于当前的这样一个由我们自己每天所生成、处理和存储的大量数据的“大数据”时代,使得越来越多的企业组织机构开始意识到,更有效地管理数据将是他们未来业务成功的关键要素。因此,数据中心也成为当下增长最快的市场之一。

根据最新的预测显示,全球未来对于以太网光收发器的驱动力将主要来自大型数据中心,电信运营商和传统企业的快速增长。而根据Dell‘Oro集团根据2015年全球以太网服务器出货量的预测,10GbE服务器将在2016年占据大的市场份额,而25GbE服务器的市场份额将在2017年实现快速增长。

在过去,传统企业的数据中心主要关注于数据存储和准备灾难恢复方面,但从未对实时的多用户数据检索和突发的大流量访问的承载能力提出过多要求。然而,随着大数据的出现,数据中心的操作运营正逐渐从数据存储转移到基于需求的实时数据分析和处理。企业和个人消费者越来越多地要求越来越多的实时数据访问。许多中小型企业(SME)负担不起通过自建的大型数据中心来支持这类大数据服务,故而他们的这些需求可以通过借助云计算来满足。一些预测称,未来企业网络中云服务方面的支出将占到IT预算的高达三分之一到一半。

在云计算的快速增长的驱动下,大型数据中心正在飞跃发展。全球的许多互联网巨头目前都已经将云服务作为其未来的重要战略。他们在全世界范围内广泛的寻找合适的地方建立巨型数据中心,希望抓住更大的全球云计算市场的份额。甚至尽管许多新兴的互联网巨头在意识到云计算将会是整个网络行业的未来的关键方面起步较晚,但他们也开始在国内外加大对于其数据中心的投资。

三级网络架构与二级叶脊网络架构

与传统的、流量是由本地客户端到服务器交互(南北走向)为主的企业数据中心相比,大型互联网数据中心的网络流量主要是由服务器到服务器的流量(东西走向),是云计算应用程序所必需的。这些数据中心的用户数量巨大,他们有多样化和分散的需求,他们需要不间断的用户体验。互联网数据中心需要更高的带宽和更有效的网络架构来处理来自大量用户的尖峰业务需求,例如对于在线音乐、视频、游戏和购物的需求。

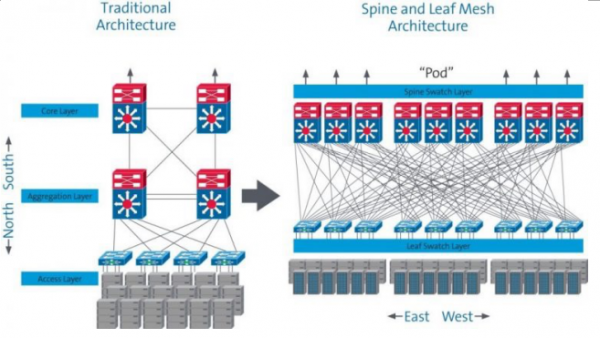

目前,主流的三级树型状网络架构是基于传统的南北走向传输模型。当某台服务器需要与不同网段的另一台服务器通信时,必须通过接入层——汇聚层——核心层——汇聚层——接入层这样的一个路径。在具有数千台服务器互相通信的大数据服务的云计算环境中,这种模型是无效的,因为其会消耗大量的系统带宽并引发延迟性的问题。为了解决这些问题,近年来世界上的大型互联网数据中心越来越多地使用叶脊(spine-and-leaf)网络架构,这在服务器(东西走向)之间传输数据更加方便。参见下图1.

这种网络架构主要由两部分组成:一个脊椎交换层和叶交换层。作为其最佳功能特征,每个叶交换机在pod中连接到每台脊交换机,这极大地提高了通信效率,并减少了不同服务器之间的延迟。此外,脊叶两级网络架构避免了购买昂贵的核心层交换设备的需要,并且在业务需要保证的情况下可以使得逐渐添加交换机和网络设备以用于扩展更容易,从而节省了初始投资成本。

图1:传统的三级网络架构vs. 脊叶两级网络架构

处理脊叶两层架构的布线挑战

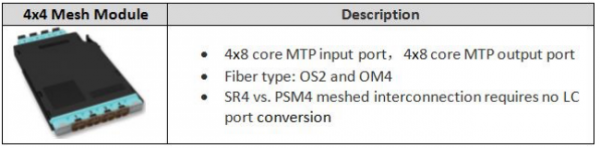

数据中心管理人员们在部署具有脊叶两级网络架构的数据中心时遇到了一些新问题。由于每台叶交换机必须连接到每台脊交换机,处理大量的网络布线成为了一大主要的挑战。例如,Corning公司的网状互连模块(下表1)解决了这一困难的问题。

表1:网格模块产品描述。

现在,许多企业用户已经开始使用高密度的40GbE交换线卡作为10GbE应用程序的一部分了。例如,高密度的10GbE SFP +线卡具有48x10GbE端口,而高密度40GbE QSFP +主板可具有36x40GbE端口。因此,可以使用40GbE线路卡在相同的布线空间和功耗条件下获得4×36 = 144×10GbE的端口,从而降低单端口10GbE的成本和功耗。

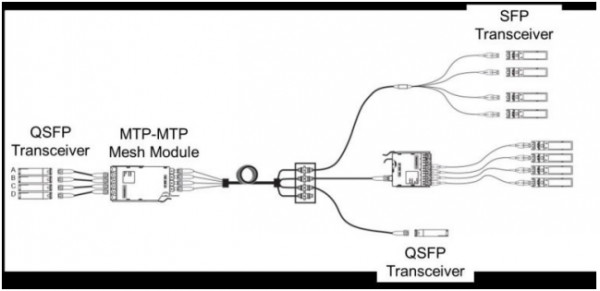

下图2显示了布线系统中网格模块的三种典型的应用。四个QSFP 40GbE通道(A,B,C和D)在网格模块的MTP输入处分为4x4的10GbE通道。然后将10GbE信道在网格模块内被打乱,使得与QSFP收发器A相关联的四个10GbE信道跨四个MTP输出上分离。其结果是,连接到一个MTP输出的四个SFP收发器从QSFP收发器A,B,C和D中的每一个接收10GbE信道。因此,我们在QSFP脊柱交换器端口和叶交换机端口之间实现了全网状10GbE架构连接,而不必在MDA处断开到LC连接。

图2:布线系统中的网格模块的三种典型应用。

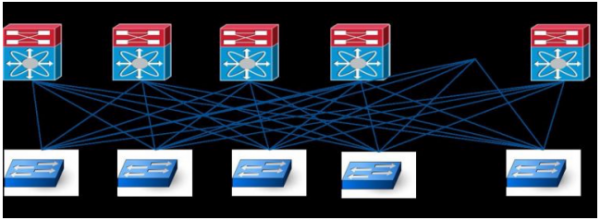

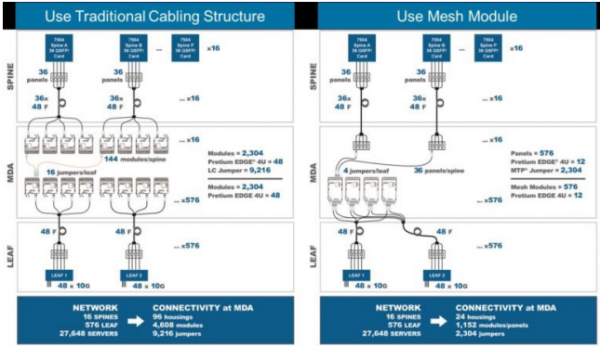

下面的示例显示了如何在主分布区(MDA)优化的脊柱和叶片配置的布线结构。例如,我们使用具有48x10GbE SFP +端口线卡的叶交换机和具有4x36x40GbE QSFP +端口线卡的脊柱交换机。如果叶交换机具有3:1的超额预订比率,则来自每个叶交换机的16x10GbE上行链路端口必须连接到16台脊柱交换机。假定来自脊柱交换机的40GbE端口作为四个10G端口运行,则每个脊柱交换机必须连接4x36x4 = 576个叶交换机,如图3所示。

图3:在10GbE应用中的脊柱和叶两级网络拓扑架构

图4:全交叉连接布线结构与脊叶网架构MDA的比较

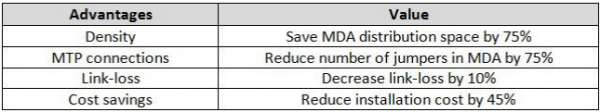

如果您企业使用传统布线以实现脊叶交换机的完全架构网络,则每台脊柱交换机的40GbE QSFP +端口通过MDA中的MTP至LC模块分为4x10GbE通道,然后通过交叉连接跳线以及连接到叶交换机的10GbE通道的相应数量的MTP-LC模块(如图4的左侧所示)。传统的方法没有被广泛使用,因为布线系统非常复杂,成本相对较高,并且在MDA需要大量的机架空间。在这种情况下,网格模块可以成为解决这些问题的一个很好的解决方案。如图4的右侧所示,在MDA中的网络模块的情况下,叶交换机完全网格的实现,不必通过一个MTP至LC的模块将脊交换机的40GbE端口拆分成10GbE信道。这种方法大大提高了MDA布线架构,并且对用户有很大的价值,如下表2所示。

表2:在MDA中的网格模块的优势。

结论

随着数据中心网络带宽需求的增加,数据中心骨干网逐渐从10GbE升级到40GbE,未来将达到100GbE.因此,通过使用现在分解为4×10GbE的40GbE和将来的100GbE分解成4×25GbE,脊叶网络架构将是用于支持大数据传输的经济和高效的网络架构。使用网格模块实现脊叶网络的完全架构网络支持当前的40GbE网络,并且还允许实现到未来的100GbE网络能力的无缝过渡。